Nueva jornada de Capacitación de Instructores

Tenemos el grato placer de recibir a los alumnos de Red Proydesa que comienzan su camino de capacitación como Instructores. Su presencia confirma y jerarquiza nuestra labor áulica en cada una de sus respectivas Academias.

Como una muestra más de la calidad de nuestro servicio educativo, las Academias de la RED se nutren de sus alumnos formados para ampliar el staff docente, una característica de valor cualitativa que ha demostrado su efectividad a lo largo de los años.

Las evaluaciones diagnósticas demostraron un notable desempeño y son el reflejo del trabajo constante. Por otro lado, los instructores de CCNA 1 inauguraron la Capacitación de la Versión 6 de la currícula de CCNA en Español.

Inteligencia Artificial: guía rápida para entenderla

Dos de los términos que últimamente suenan asociados a inteligencia artificial son machine learning y deep learning. Ambos tienen su traducción en castellano (aprendizaje automático y aprendizaje profundo), aunque no siempre se utilice. Son dos formas de inteligencia artificial –una tecnología que funciona desde hace décadas– y que se engloban una a la otra.

Se puede decir que el machine learning tiene una vertiente que se denomina deep learning. Las dos tecnologías hacen referencia a sistemas capaces de aprender por sí solos. La diferencia entre ambos estriba en el método de aprendizaje. El de deep learning es más complejo y también más sofisticado. Es también más autónomo, lo que quiere decir que una vez programado el sistema la intervención del ser humano es mínima.

La diferencia entre machine learning y deep learning es que la segunda técnica leva el aprendizaje a un nivel más detallado. El sistema en este caso v a por capas o unidades neuronales. De hecho el funcionamiento de estos algoritmos trata de imitar el del cerebro.

En deep learning cada capa procesa la información y arroja un resultado que se revela en forma de ponderación. Es decir, cuando una unidad de un sistema analice una foto en busca de perros concluirá que dicha imagen es en un 78% de probabilidad un perro y en un 22% no lo es.

¿Qué es y que no Inteligencia Artificial?

De repente, gracias a la llegada de los bots a Facebook Messenger como atractivo, todo parece ser "bots". Empresas “competidoras” como Telegram también ofrecen su plataforma para crearlos, y muchas empresas de servicios y ventas los están implementando en su chat de atención al cliente. También es posible utilizarlos incluso en aplicaciones de noticias como la de Quartz.

Los bots eran la próxima gran revolución, y para este 2017 se esperaba una gran repercusión en ferias tecnológicas, pero parece que el flujo creativo ha parado. Ni en el pasado IFA de 2016 ni en el CES han sido relevantes entre las tendencias para el nuevo año, y a la espera del Mobile World Congress, de momento parece que quedan como una solución que muchas empresas pueden emplear para intentar atraer y resultar atractivas, más que para ofrecer una utilidad real.

A esto recuerda, por ejemplo, la fiebre que hubo hace unos años con el uso de códigos QR. En muchos lugares podían resultar útiles, pero en la mayoría sólo eran un elemento que no aportaba nada a la experiencia de uso, ni siquiera agilizaba. Los bots que conocemos hasta ahora, o al menos la mayoría de ellos, tampoco pueden ser llamados inteligencia artificial, en tanto que no aprenden de nosotros ni de sus programadores sin que éstos alteren su código. Y seguir órdenes empleando algoritmos, paso a paso, no es inteligencia artificial.

Slack, por ejemplo, anunció su integración con Watson, de IBM. Ese es un paso interesante, pues Watson es capaz de aprender e identificar patrones y añadir su aprendizaje a sus bases de datos, de manera que se va mejorando a sí mismo y en el futuro es capaz de mejorar la forma de afrontar una situación. El resto de bots, como el típico de Giphy, tendrán que esperar a conocer mejor al usuario y a darle información mucho más precisa para acercarse a la consideración de “inteligentes”.

Para el usuario final, por ejemplo, la manera en que Siri responde al usuario tampoco es inteligencia artificial per se, aunque las técnicas de machine learning que Apple está empleando para mejorar las respuestas y su conocimiento sí lo sean. Y es que el Siri que podemos encontrar ahora es radicalmente opuesto al que llegó en 2011 con el iPhone 4S.

Google Assistant, por su parte, es más conversacional, y tiene en cuenta elementos como el contexto, que sí interioriza y de los cuales es capaz de aprender para mejorar en el futuro. En ese sentido, aunque no está en manos del público, AlphaGo es una de las mejores muestras de inteligencia artificial aplicada que se ha puesto en práctica, con una implementación brillante de las últimas tendencias (deep learning, machine learning, etc).

Por su complejidad, pasará tiempo hasta que la inteligencia artificial de verdad se expanda como se expandieron los bots el pasado año. Sin embargo, la informática está en un punto tan avanzado en que sin inteligencia artificial se pueden hacer muchas cosas que también parecen milagrosas, pero sólo es ciencia.

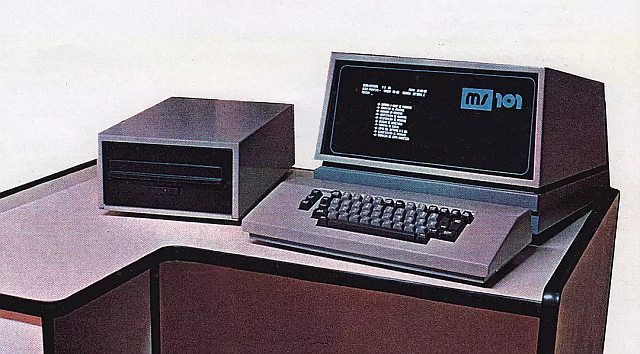

Historias olvidadas: la computadora argentina que compitió con IBM

Hoy estamos acostumbrados a que, en general, los dispositivos electrónicos provengan de Asia. Sin embargo, a mediados de la década de los setenta, el escenario en la Argentina era bien diferente. Por entonces, FATE División Electrónica, una empresa privada nacional, había logrado desarrollar y comercializar calculadoras electrónicas y había desplazado del liderazgo del mercado argentino a la italiana Olivetti, una de las principales empresas del rubro por aquellos años. Cuando el destello de la División Electrónica de FATE se apagaba, en Córdoba surgía Microsistemas. Esta pyme le disputaría al gigante estadounidense IBM el mercado argentino de las computadoras graboverificadoras.

Nicolás Wolovick y Gustavo del Dago se interesaron por la trayectoria de Microsistemas y, especialmente, por su logro fundacional, la MS101, una computadora que haría historia. Wolovick es docente e investigador en Ciencias de la Computación de la Facultad de Matemática, Astronomía, Física y Computación (FAMAF), de la Universidad Nacional de Córdoba (UNC). En el caso de del Dago, su especialidad es el desarrollo de software y también se desempeña como profesor de computación. Ambos, además, son entusiastas de la “arqueología computacional”, una disciplina en ciernes que intenta “brindar nuevos aportes a la gente que está haciendo historia desde la perspectiva de la técnica y la ingeniería”, explica Del Dago. La arqueología computacional suma adeptos en una iniciativa denominada SAMCA (Salvando la Memoria de la Computación Argentina).

El surgimiento de Microsistemas fue obra de Julio Eduardo Bazán, un contador que en la década de los sesenta tenía una empresa, PROCECOR, con la que cargaba datos para entidades como Obras Sanitarias de la Nación (Córdoba) o el Banco de la Provincia de Córdoba.

En aquellos años, la información se almacenaba en tarjetas de papel perforadas o en cintas magnéticas. El disco flexible de 8 pulgadas había sido introducido por IBM recién en 1971. En el esquema de trabajo de las primeras computadoras era fundamental cargar y verificar los datos, lo que se realizaba con unas máquinas denominadas graboverificadoras. La carga se efectuaba en los puntos de generación de la información (un banco, por ejemplo) a través de listados duplicados, a fin de que las graboverificadoras constataran que estaban bien, y posteriormente se los grababa en tarjetas o cintas –y tiempo después, en discos flexibles– para transportarlos a los centros de cómputo donde se procesaban. La empresa que dominaba el mercado de estas máquinas era IBM.

En la medida en que Bazán expandía su negocio necesitó más graboverificadoras y decidió desarrollar un equipo propio para no pagar los altos costos de los importados. Para ello, convocó a un grupo de profesionales que se desempeñaban en empresas multinacionales de informática radicadas en Córdoba y, aprovechando el surgimiento del microprocesador, se largaron a hacer su propia computadora. Se comenzó a trabajar en el prototipo en 1976, al año siguiente estaba listo y se inició su comercialización en 1978. Se trataba de la MS101, que primero prestó servicios en el propio centro de cómputos de Bazán y que, posteriormente, se transformó en un producto en sí mismo, del que se vendieron cerca de trescientos ejemplares en todo el país.

Microsistemas tuvo un crecimiento rápido, pero a finales de los setenta comenzó a experimentar problemas financieros y debió asociarse con otra empresa: CEPICO. A mediados de los ochenta, Microsistemas fue vendida a SADE, del grupo Pérez Companc. Para entonces, el porcentaje de desarrollo propio puesto en cada producto había disminuido sustancialmente y se incorporaban cada vez más elementos importados. Finalmente, la empresa desapareció en los años noventa, tras transformarse en una mera armadora de clones.

Los secretos de la MS101

La MS101 era una computadora de propósito específico –a diferencia de las actuales, que son de propósito general–, con un teclado, una disquetera externa y un gabinete con pantalla de fósforo verde. Además, poseía un procesador Intel 8080 –en la vanguardia de la época– con 8 kB de memoria RAM. El diseño había sido obra de Juan Salonia y el programa de Héctor Múller, ambos colaboradores de Bazán. La MS101 permitía cargar 80 caracteres por línea y corregirlos si había un error, dado que disponía de “backspace”, algo que no poseían todas las máquinas de la época. El software contaba con un menú con diversas opciones, podía establecer formatos en los datos (fechas, numéricos) y también validaba y ordenaba la información.

Cuando Microsistemas se embarcó en la tarea de desarrollar una computadora propia no contaba con antecedentes al respecto. Al parecer, la intención de Bazán y su gente, más que incursionar en el negocio de la fabricación de computadoras, era apuntalar el centro de datos que ya poseían. Tampoco quienes se abocaron a la tarea de construir la MS101 tenían trayectoria en investigación o desarrollo en este campo, a diferencia de lo ocurrido con FATE, que se había nutrido de especialistas formados en la Universidad de Buenos Aires.

Tanto el desarrollo de la MS101 como su fabricación, eran extremadamente artesanales. Microsistemas contaba con aproximadamente una docena de empleados que se encargaban de producir el hardware y el software. La disquetera, el teclado y el monitor eran importados. La impresión de los circuitos y los gabinetes de chapa eran producidos por proveedores externos.

El personal de la empresa, a su vez, realizaba el mantenimiento de los equipos en los establecimientos de los clientes y cualquier modificación que estos desearan. Las máquinas eran una “caja negra” y solo la gente de Microsistemas accedía a ellas. No había tampoco una concepción moderna que separase el programa del hardware, sino que ambas cosas estaban indisolublemente unidas. Es probable que esto haya respondido a una política comercial pensada para que los clientes permanecieran atados al servicio de soporte de Microsistemas, pero también es factible que haya sido la consecuencia de un trabajo excesivamente artesanal.

En el caso de la programación, según Wolovick, en Microsistemas ni siquiera usaban un “ensamblador” (programa de interfaz entre el código de máquina que lee el hardware y el lenguaje que emplea el programador), sino que directamente ponían números en la memoria, algo “increíblemente artesanal y primitivo”. Pero, también, al ser un producto tan artesanal, sus diseñadores tenían un dominio completo de él y eso favoreció el rápido desarrollo de versiones a medida de clientes específicos. Por ejemplo, en la antigua cementera Corcemar se instalaron máquinas conectadas a balanzas electrónicas para medir la producción de hormigón y, para la financiera Denario, además de colocarle un software que calculaba intereses, se lograron hacer transmisiones a través de ARPAC, la red digital de ENTEL, para sincronizar la información de las sucursales durante la noche. Este procedimiento no era novedoso, pero sí lo era emplear computadoras de bajo rango y costo para hacer lo mismo que hasta ese momento solo se realizaba con grandes máquinas.

El éxito de la MS101 llevó al desarrollo de modelos más avanzados, como la MS104, pero con el correr del tiempo Microsistemas fue elaborando cada vez menos software propio e incorporando copias “pirateadas” de programas importados como Basic y Cobol, a los que les traducía los manuales, les agregaba la sigla “MS” y posteriormente comercializaba.

Bazán y su gente tampoco exploraron la posibilidad de hacer una computadora de propósito general, aunque la MS101 tenía potencialidad para eso. De hecho, era factible cargar a partir del disquete de arranque un programa oculto que permitía incorporar otras funcionalidades, como la de pequeños juegos.

Con respecto al precio de estas máquinas, aunque Wolovick y fel Dago no consiguieron información precisa, estiman que osciló entre 12.000 y 14.000 dólares, lo que no las hacía baratas, pero sí mucho más económicas que sus homólogas de IBM.

¿Silicon Córdoba?

El éxito que tuvo en su momento Microsistemas, contemporáneo al fabuloso ascenso del mítico Silicon Valley estadounidense, inevitablemente lleva a la siguiente pregunta: ¿Podría haber germinado algo similar en Córdoba? Ni Wolovick ni del Dago creen que la comparación sea pertinente. Había muchas diferencias entre una y otra experiencia.

“No hubo un plan de desarrollo tecnológico”, opina del Dago sobre Microsistemas, y agrega: “Había una muy buena capacidad para usar la tecnología disponible frente a la necesidad local y encarar la resolución de problemas. Pero en ningún momento estaba la idea de correr la frontera de la computación, crear un lenguaje de programación nuevo o una máquina novedosa”.

En Microsistemas también había mucha improvisación. Los primeros equipos salían de fábrica sin número de serie, algo que posteriormente se corrigió porque dificultaba su identificación para el mantenimiento. Tampoco había controles de calidad, aunque las máquinas eran robustas.

“Podrían haber sobrevivido más tiempo, pero habrían terminado armando clones, ya que la ‘comoditización’ de las partes de computadoras que vino en la década de los ochenta fue muy fuerte. Se le podría haber agregado valor desarrollando software, pero no eran buenos en eso”, dice Wolovick. Su colega del Dago, en cambio, cree que “con más tiempo probablemente podrían haber mejorado su forma de desarrollar software”.

A pesar del fracaso final de Microsistemas, Wolovick destaca que la influencia que tuvieron en la informática de Córdoba quienes estuvieron involucrados en esta experiencia fue enorme, “para bien y para mal”, y se proyecta hasta el presente. Se trata de una experiencia testigo de una época en la que la Argentina casi salta sobre su propia sombra de subdesarrollo y también de una metodología de abordaje de los desafíos tecnológicos que a veces brindaba éxitos inmediatos resonantes, pero trastabillaba a la hora de darles continuidad.

Fuente: Agencia TSS